特定のWebサイトの情報を定期的に監視して取得したい事例

こんにちは、中小企業のIT活用を支援する、中小企業診断士の髙仲です。

ITを活用した中小企業の支援事例として、特定のWebサイトの情報を定期的に取得して、監視できるようにしたい、という要望に応えた事例を紹介します。

なぜ監視できるようにしたいか?

日々更新されるWebサイトの状況を、その度に人の手で一つ一つチェックすることはとても大変な作業です。

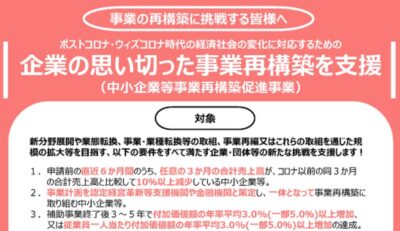

例えば、今回の事例ではありませんが、よくあるニーズとしては賃貸サイトにおける中古物件情報の収集や、通販サイトにおける商品価格の取得等があります。

ポータルサイトと呼ばれる、情報が集まるサイトに対して、日々人の手で特定の情報を探してチェックする作業を自動化したいという話があり、支援を行いました。

どのように解決するか?

Webサイトから情報を取得する技術は、「スクレイピング」と呼ばれ、様々なプログラム言語や環境で実現する方法が知られています。

ウェブスクレイピング(Web scraping)とは、ウェブサイトから情報を抽出するコンピュータソフトウェア技術のこと。ウェブ・クローラー(Web crawler) あるいはウェブ・スパイダー(Web spider)とも呼ばれる。

引用元: Wikiペディア

簡単に述べると、WebサイトのHTML構造を分析して、求める情報が記載されている箇所のみを抜き出してくるという技術です。

なお、どのようなサイトを対象にしても良い訳ではなく、次のことをチェックしてから検討する必要があります。

- 対象サイトの利用規約に抵触しないか

- 必要以上のアクセス過多となる仕様になっていないか

- API(サイト側が提供する情報取得の窓口)は存在しないか

いずれも、相手方のサイトに迷惑がかからない前提で作ることが重要です。

今回の事例では、小規模であったためにプログラムを自作して対応しました。

効果は?

毎日の手作業でリンクをクリックする事務作業が、ツールを実行すれば自動で情報を取得できるようになりました。

定型的な作業は、一括りの業務としてパッケージ化することで、IT活用による大幅な業務改善が見込めます。

あなたの会社でも、もし毎日同じようなことを繰り返し人力で行っている作業がありましたら、ぜひご相談下さい。

よくわからないんだけど?

スクレイピングの機能を体感できる、有名なWebサイト「https://www.import.io/」があります。

下記のサイトで紹介されていますので、参考にしてみてください。